MOOC学习python爬虫学习之入门

发表于|更新于|编程

入门

几个库

Requests:自动爬取HTML页面,自动网络请求提交

robots.txt:网络爬虫排除标准

Beautiful Soup:解析HTML页面

Scrapy:爬虫框架

采用Python 3.x系列版本

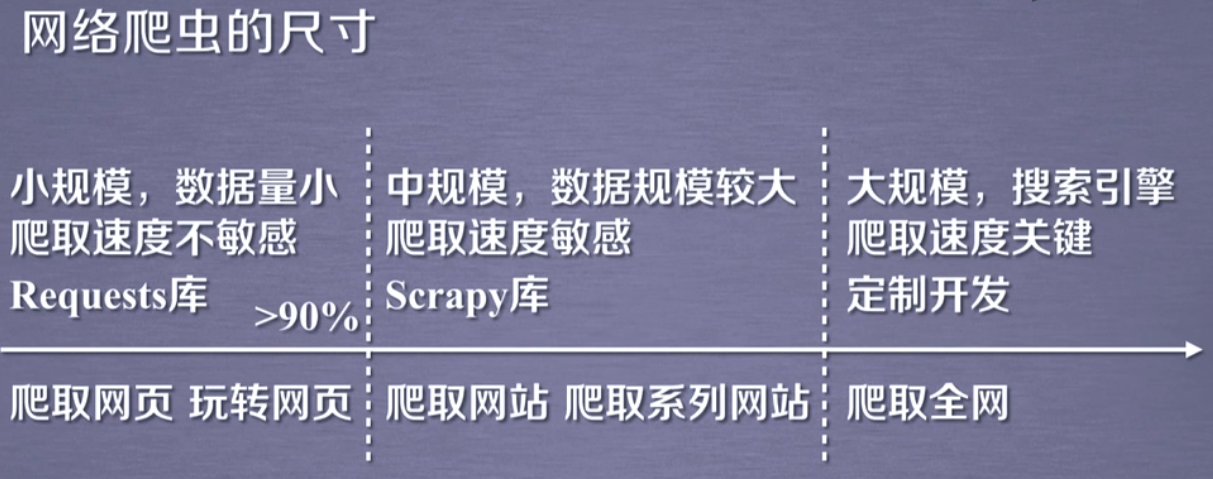

网络爬虫尺寸

文章作者: GreenHatHg

版权声明: 本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 GreenHatHGのBlog!

相关推荐

2025-12-18

火车头使用教程

声明:本教程无任何盈利目的,仅供学习使用,也不会对网站运行造成负担,请勿用于任何商业用途。 火车头简介火车采集器官网-网页抓取工具火车头采集器免费网站采集软件 火车采集器,一款专业的互联网数据抓取、处理、分析,挖掘软件,可以灵活迅速地抓取网页上散乱分布的数据信息,并通过一系列的分析处理,准确挖掘出所需数据。火车采集器历经十二年的升级更新,积累了大量用户和良好口碑,是目前最受欢迎的网页数据采集软件。 简单来讲,就是使用软件来简化我们的爬虫过程,在整一个过程中,不需要编写代码就能够实现爬虫逻辑。 举例爬取任务需要分页爬取所有页面,并对页面上所有感兴趣的条目进一步爬取二级URL 新建任务添加一个任务 网址采集规则-网址获取 起始网址填上【第一页的URL】 网址获取选项的意思:提取当前页面上想要爬取的条目的URL,比如xx网第一页上的符合条件的所有商品链接。 12345678910111213141516171819202122<div class="Z_list-box">...<div class="pic-box"...

2025-12-18

MOOC学习python爬虫之中国大学排名

定向爬虫 功能描述 还得确定排名信息是不是写在HTML里面 程序设计 实例代码 123456789101112131415161718192021222324252627282930313233import requestsfrom bs4 import BeautifulSoupimport bs4def getHTMLTest(url): try: r = requests.get(url) r.raise_for_status() r.encoding = r.apparent_encoding return r.text except: return ""def fillUnivList(ulist, html): soup = BeautifulSoup(html, "html.parser") for tr in soup.find('tbody').children: if isinstance(...

2025-12-18

MOOC学习python爬虫学习之Requests

Python-Requests库 安装12pip3 install requests# python3 deepin15.6 Requests库的7个主要办法 requests.request() 构造一个请求,支撑以下各方法的基础方法 requests.get() 获取HTML网页的主要方法,对应于HTTP的GET requests.head() 获取HTML网页头信息的方法,对应于HTTP的HEAD requests.post() 向HTML网页提交POST请求的方法,对应于HTTP的POST requests.put() 向HTML网页提交PUT请求的方法,对应于HTTP的PUT requests.patch() 向HTML网页提交局部修改请求,对应于HTTP的PATCH requests.delete() 向HTML页面提交删除请求,对应于HTTP的DELETE request.get() requests.head() HEAD获取头部信息,没有html主体,故r.text为空‘ requests.post() requ...

2025-12-18

MOOC学习python爬虫之beautifulsoup

beautifulsoup4 安装12pip3 install beautifulsoup4#python 3.6 deepin15.7 bs4理解以及引用 bs类基本元素 Name属性 Attribus属性 NavigableString属性 Comment属性 总结 HTML基本格式以及遍历 下行遍历 上行遍历 平行遍历 迭代类型:只能放在循环里面 pretiffy()美化代码 find_all name attrs recursive string 拓展办法

2025-12-18

MOOC学习python爬虫之简单实战

简单抓取京东,亚马逊,搜索引擎信息,ip归属地查询 京东无意外,status_code返回202 天猫status_code返回503。模拟一波head 搜索引擎 google: 1https://www.google.com/search?q=keyword 爬取网页图片并且保存 IP地址归属地自动查询

评论